探索更广泛的影响要求对AI治理的影响

随着机器学习算法和其他人工智能(AI)工具的日益普及,一些政府和机构已开始引入旨在确保其在道德上得到设计和实施的法规。例如,去年,神经信息处理系统(NeurIPS)会议为所有提交与AI相关的研究的作者引入了与道德相关的新要求。

牛津大学AI伦理研究所,计算机科学系和人类未来研究所的研究人员最近发表了一篇观点论文,讨论了诸如NeurIPS会议提出的要求可能产生的影响和影响。这篇发表在《自然机器智能》上的论文还提出了一系列措施,可以最大限度地提高这些要求的成功机会。

进行这项研究的研究人员之一Carina E. Prunkl对TechXplore表示:“去年,NeurIPS提出了一项要求,即提交论文的作者必须在论文中包含更广泛的影响力陈述。” “很多人-包括我们在内-感到惊讶。为此,我们决定就该主题写两篇文章:研究人员指南,介绍如何开始思考研究的更广泛影响并撰写更广泛的影响说明,以及这篇有远见的文章,实际上是要指出这种更广泛的影响要求的一些潜在影响。”

预测和总结给定研究的可能影响是一项非常复杂且具有挑战性的任务。在给定的技术工具或技术可以在广泛的设置范围内具有多种应用的情况下,甚至更具挑战性。

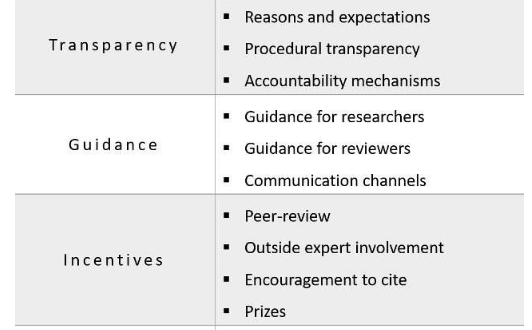

Prunkl和她的同事们在其论文的基础上,研究了不同的治理机制,以描绘NeurIPS提出的要求可能带来的好处,风险和挑战。此外,他们提出了一系列可减轻潜在挑战的策略,将其分为四个关键类别:透明性,指导性,激励性和审议性。

普鲁克说:“我们的总体目标是通过提高人们对某些潜在陷阱的认识,为有关社区主导的治理机制的持续讨论做出贡献,并提出建设性的建议,以改善这一过程。” “我们通过讨论其他治理举措(例如机构审查委员会)的效果来开始讨论,这些举措本质上是相似的,并且还让研究人员撰写有关其研究影响的陈述。”

Prunkl和她的同事考虑了以前的AI治理计划,该计划要求研究人员准备有关其工作影响的陈述,并着重介绍了从此类陈述中学到的一些经验教训。然后,他们讨论了NeurIPS更广泛的影响声明要求的潜在利益和风险。最后,他们为会议组织者和整个ML社区准备了一份建议列表,可以帮助他们提高此类声明对AI的发展产生积极影响的可能性。

Prunkl说:“我们列出的一些好处是对AI潜在潜在有害影响的预期得到改善和缓解,以及研究社区与决策者之间的交流得到了改善。” “如果执行不当,可能存在陈述质量低下的风险,有可能认为道德操守运动,甚至有可能使道德琐碎化,因为这表明实际上有可能充分预期对道德操守的影响。这边走。”

为了评估和预测给定技术的更广泛影响,研究人员理想地应该具有诸如伦理学或社会学等学科的背景,并且对理论框架和先前的经验结果具有扎实的知识。Prunkl和她的同事在论文中概述了过去治理计划的失败或负面影响的一系列可能的根本原因。这些原因包括在试图确定给定研究或技术工具的更广泛影响时遇到的固有困难,以及机构或社会的压力以及缺乏帮助研究人员撰写其陈述的通用准则。

普伦克说:“我们的主要建议集中在四个关键主题上:首先,提高透明度和设定期望值,其中包括目的,动机和期望的交流,以及如何评估这些陈述的程序透明度。” “第二,提供指导,其中包括有关如何编写这些陈述的指导,以及针对裁判如何评价它们的指导。”

Prunkl和她的同事们在论文中还强调了制定激励措施的重要性。编写高质量的声明可能既昂贵又耗时,因此,他们认为机构应采取激励措施,鼓励更多的研究人员投入大量的时间和精力来反映工作的影响。

Prunkl解释说:“一种解决方案是将语句的评估集成到同行评审过程中。” “其他选择包括设立指定奖项,并鼓励作者引用其他影响力陈述。”

Prunkl和她的同事们强调的第四个主题与公众和社区的审议有关。最后一点超出了更广泛的影响力陈述的范围,研究人员认为这应该以任何旨在支配AI的干预为基础。他们特别强调需要更多的论坛,以使ML社区讨论旨在解决AI风险的潜在措施。

Prunkl说:“寻找有效确保AI安全,负责任地开发的治理解决方案是当今最紧迫的挑战之一。” “我们的文章强调需要认真考虑这样的治理机制,并仔细思考可能产生的,可能破坏预期利益的风险和挑战。最后,我们的文章强调必须对此类治理机制进行社区审议。”

Prunkl和她的同事希望他们准备的建议列表将帮助计划组织更广泛的影响要求以应对与AI开发相关的挑战的会议组织者。研究人员目前计划加强与ML研究人员的合作,以进一步帮助他们准备研究影响陈述。例如,他们计划与研究人员共同设计会议,他们将合作创建资源,以帮助团队准备这些陈述并确定其工作的更广泛影响。

普伦克说:“关于影响力声明的辩论确实突出表明,对于应采用哪种治理机制以及应如何实施治理机制,缺乏共识。” “在我们的论文中,我们强调需要围绕此类机制进行持续的,建设性的审议。针对这一需求,作者之一Carolyn Ashurst(与Solon Barocas,Rosie Campbell,Deborah Raji和Stuart Russell一起)组织了NeurIPS主题为“驾驭人工智能研究的更广泛影响”的研讨会。”

在Ashurst和她的同事组织的研讨会上,与会人员讨论了NeurIPS的影响声明和道德审查,以及有关负责任的研发理念的更广泛的问题。此外,组织者还探索了ML研究生态系统中不同方在导航更广泛的影响陈述的准备中可以扮演的角色。

将来,Prunkl和她的同事计划为与AI治理有关的建设性审议和讨论创造更多机会。他们的希望是,ML社区和参与AI使用的其他各方将继续共同努力,建立旨在有效解决ML研究可能产生的问题的规范和机制。此外,研究人员还将进行进一步的研究,旨在分析影响力陈述以及对这些陈述的一般态度。

Prunkl说:“分析会议预印本的影响陈述的工作已经浮出水面,既令人鼓舞,又令人担忧。” “现在会议文件的最终版本已经公开,我们/ GovAI /我们的研究小组已经开始分析这些陈述,以了解研究人员如何对实践中的要求做出回应。此外,还需要做更多的工作来了解当前的态度。 ML研究人员针对此要求的工作。ElementAI研究人员的工作发现NeurIPS作者的反应不一;尽管有些人认为这一过程很有价值,但另一些人则提到了我们论文中强调的许多挑战,例如将这一要求描述为“另一种负担已经落在了工作过度的研究人员的肩上。”

标签: AI治理