基于局部示例推断全局时间结构的循环神经网络

大多数计算机系统旨在存储和操作信息,例如文档、图像、音频文件和其他数据。虽然传统计算机被编程为对结构化数据执行特定操作,但新兴的神经启发系统可以学习更自适应地解决任务,而无需进行设计以执行一组类型的操作。

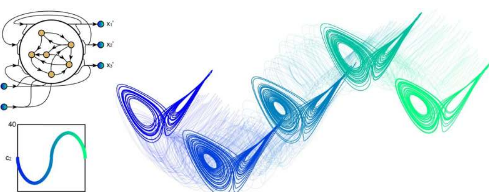

宾夕法尼亚大学和加利福尼亚大学的研究人员最近训练了一个循环神经网络(RNN),以仅根据本地数据示例来调整其对复杂信息的表示。在Nature Machine Intelligence上发表的一篇论文中,他们介绍了这种 RNN,并概述了支持其功能的关键学习机制。

“每天,我们都会操纵有关世界的信息来做出预测,”进行这项研究的研究人员之一杰森·金告诉 TechXplore。“我可以煮多久这种面,它会变湿?我可以在高峰时间之前上班多长时间?这种信息表示和计算大致属于工作记忆的范畴。虽然我们可以对计算机进行编程来构建模型面食质地或通勤时间,我们的主要目标是了解神经网络如何仅通过观察示例来学习构建模型和做出预测。”

Kim、他的导师 Danielle S. Bassett 和他们团队的其他成员表明,神经网络学习进行预测的两个关键机制是关联和上下文。例如,如果他们想教他们的 RNN 改变一首歌的音高,他们会输入原始歌曲和其他两个版本的歌曲,一个音调稍高,另一个音调稍低。

对于音高的每次变化,研究人员都会使用上下文变量“偏置”RNN。随后,他们训练它在其工作记忆中存储原始歌曲和修改后的歌曲。这允许 RNN 将音高移动操作与上下文变量相关联,并操纵其内存以进一步改变歌曲的音高,只需更改上下文变量即可。

“当我们的一位合作者 Zixin Lu 告诉我们可以学习在工作记忆中存储信息的 RNN 时,我们知道我们的目标就在眼前,”Kim 说。“从理论上讲,RNN 根据一个方程在时间上向前演化。我们推导出了一个方程,该方程量化了上下文变量的微小变化如何导致 RNN 轨迹的微小变化,并询问需要满足什么条件才能实现微小的变化。 RNN 的轨迹以产生所需的表示变化。”

Kim 和他的同事观察到,当训练数据示例之间的差异很小(例如,音调的小差异/变化)时,他们的 RNN 将这些差异与上下文变量相关联。值得注意的是,他们的研究还确定了一种简单的机制,通过该机制,神经网络可以使用工作记忆来学习计算。

“一个很好的例子实际上可以在跟踪猫的流行视频中看到,”金解释道。“在这里,摄像机周期性地进出视野,只有当摄像机不在视野范围内时,记录的猫才会更近一些,而在视野范围内保持静止状态。只需观察前几个动作,我们就可以预测最终结果:一只近端的猫。”

虽然过去的许多研究表明神经网络如何操纵它们的输出,但 Kim 和他的同事的工作是最早确定一种简单的神经机制的工作之一,通过该机制 RNN 操纵他们的记忆,同时即使在没有输入的情况下也能保留它们。

“我们最显着的发现是,RNN 不仅学会了连续操纵工作记忆中的信息,而且当仅在非常局部的示例上进行训练时,它们实际上对全局结构做出了准确的推断,”Kim 说。“这有点像在只听了前几个音符后,就能准确预测肖邦幻想即兴曲的旋律。”

Kim 和他的同事最近的论文介绍了一个定量模型,其中包含可证伪的工作记忆假设,这也可能与神经科学领域相关。此外,它概述设计原则,可以帮助那些通常被视为黑盒子(即,不解释清楚他们的预测背后的过程)神经网络的理解。

“我们的研究结果还表明,如果设计得当,神经网络具有不可思议的能力,可以在训练示例之外准确地概括,”Kim 说。“我们现在正在探索许多其他令人兴奋的研究方向。这些方向从研究 RNN 内部表示在学习过程中的变化到使用上下文变量在记忆之间切换,再到无需训练即可在 RNN 中编程计算。”

标签: 循环神经网络