打破AI让它们变得更好

今天用于图像识别的人工智能系统非常强大,具有巨大的商业应用潜力。尽管如此,当前的人工神经网络——支持图像识别的深度学习算法——存在一个巨大的缺点:它们很容易被稍微修改过的图像破坏。

对于希望构建更好的人工智能的研究人员来说,这种“鲁棒性”的缺乏是一个重大障碍。然而,究竟为什么会发生这种现象,以及其背后的潜在机制,仍然很大程度上是未知的。

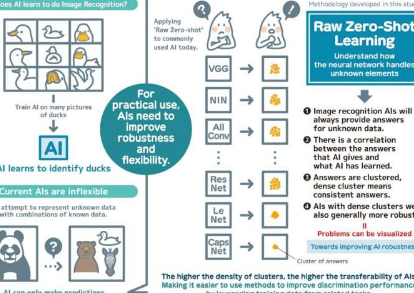

为了有朝一日克服这些缺陷,九州大学信息科学与电气工程学院的研究人员在PLOSONE上发表了一种名为“RawZero-Shot”的方法,该方法评估神经网络如何处理他们不知道的元素。结果可以帮助研究人员确定使人工智能“不健壮”的共同特征,并开发出纠正其问题的方法。

“图像识别神经网络有一系列实际应用,包括自动驾驶汽车和医疗保健诊断工具,”领导该研究的DaniloVasconcellosVargas解释道。“然而,无论人工智能训练得多么好,即使图像发生轻微变化,它也可能失败。”

在实践中,图像识别AI在被要求识别一张之前在许多样本图像上进行了“训练”。例如,如果你想让AI识别鸭子,你首先要在许多鸭子的照片上训练它。

尽管如此,即使是训练有素的人工智能也可能被误导。事实上,研究人员发现,可以对图像进行处理——虽然它在人眼看来可能没有变化——但人工智能无法准确识别它。即使是图像中的单个像素变化也会引起混乱。

为了更好地理解为什么会发生这种情况,该团队开始研究不同的图像识别AI,希望能够识别它们在面对未经训练的样本时的行为模式,即AI未知的元素。

“如果你给一个人工智能图像,它会试图告诉你它是什么,不管这个答案是否正确。所以,我们今天选取了十二个最常见的人工智能,并应用了一种新的方法,称为‘原始零——射击学习,'”巴尔加斯继续说道。“基本上,我们给AI提供了一系列没有任何提示或训练的图像。我们的假设是它们的回答方式存在相关性。它们是错误的,但同样是错误的。”

他们发现的只是这些。在所有情况下,图像识别AI都会产生答案,而答案——虽然是错误的——会是一致的,也就是说它们会聚集在一起。每个集群的密度将表明AI如何根据其对不同图像的基础知识处理未知图像。

“如果我们了解人工智能在做什么以及它在处理未知图像时学到了什么,我们可以使用同样的理解来分析为什么人工智能在面对具有单像素变化或轻微修改的图像时会崩溃,”巴尔加斯说。“利用我们获得的知识试图通过将其应用于不同但相关的问题来解决一个问题,这被称为可转移性。”

该团队观察到CapsuleNetworks,也称为CapsNet,产生了最密集的集群,使其在神经网络中具有最佳的可迁移性。他们认为这可能是因为CapsNet的动态特性。

“虽然今天的人工智能是准确的,但它们缺乏进一步实用的鲁棒性。我们需要了解问题是什么以及为什么会发生。在这项工作中,我们展示了研究这些问题的可能策略,”巴尔加斯说。

“我们必须研究提高鲁棒性和灵活性的方法,而不是仅仅关注准确性。然后我们才能开发出真正的人工智能。”

标签: